La (quasi-)faillite des sondeurs ou le retour en force du réel

Par

Publié le

5 février 2018

Partage

[vc_row][vc_column][vc_column_text css= ».vc_custom_1517817358790{margin-right: 25px !important;margin-left: 25px !important;} »]

Alors que Donald Trump, « improbable » candidat, a été intronisé 45e président des États-Unis ; alors que François Fillon s’est trouvé engagé dans la bataille de la présidentielle au nom d’un parti qui n’était pas « censé » faire de lui son coryphée ; alors que le Royaume-Uni affronte aujourd’hui un processus de sortie de l’Union Européenne qui n’aurait « décemment » jamais dû se produire, plus que jamais – et ainsi que les frères de Goncourt l’écrivaient si judicieusement dans leur Journal – « la statistique est la première des sciences inexactes ».

Grandeur et décadence

C’est par un coup d’éclat resté célèbre que le sociologue G. H. Gallup consacra la méthode moderne de sondage par échantillon encore aujourd’hui utilisée par les instituts spécialisés : a contrario d’une vaste enquête menée auprès de plus de 2 millions de lecteurs du magazine Literary Digest, qui plaçait le gouverneur républicain Landon en tête de l’élection présidentielle américaine de 1936, et sur la seule base d’un échantillon de quelques milliers de personnes construit pour être représentatif de la population globale, Gallup anticipa avec succès la victoire de Roosevelt. Douze ans plus tard, les sondages prédictifs connaissaient leur premier revers, péchant par excès de confiance en suspendant leurs publications deux semaines avant l’élection qui révéla Truman, tant la consécration de son adversaire Dewey leur semblait acquise. C’était sans compter sur la volatilité d’un électorat dont les intentions évoluèrent sensiblement dans les derniers instants de la campagne.

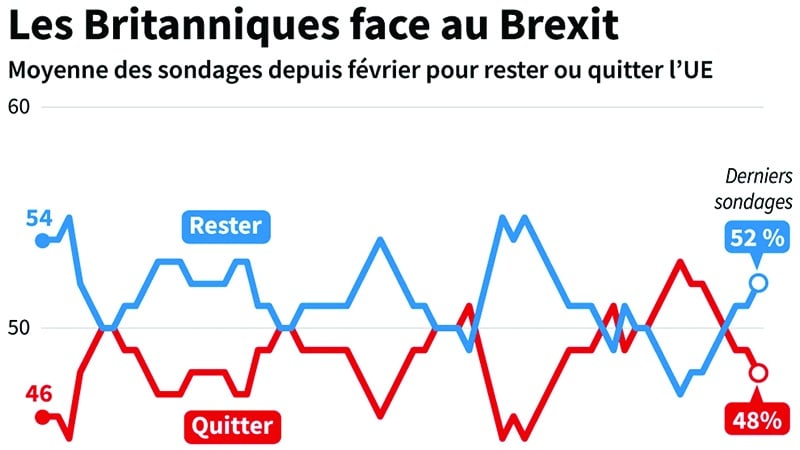

Étonnement, c’est aussi l’argument d’un retournement in extremis de l’opinion britannique qui fut retenu suite à l’enquête du British Polling Council[1], consécutive à la Bérézina sondagique de l’élection législative de 2015 au Royaume-Uni. Alors que tous les observateurs escomptaient un résultat serré entre travaillistes et conservateurs, conduisant à un inéluctable gouvernement de compromis, le scrutin s’était finalement soldé par une confortable victoire du camp de David Cameron. À ce jour, outre-Manche, on considère cet épisode comme le pire revers subi par les sondeurs dans l’histoire britannique, avec celui du Brexit.

De l’importance d’être constant

Que la méthode de sondage par échantillonnage ait longtemps fait l’affaire, alors qu’elle accumule aujourd’hui les échecs, ne relève pas d’un mauvais concours de circonstance. Au contraire, ce que nous enseignent les événements récents, c’est que l’unique constance des sondages politiques nationaux n’est paradoxalement autre que leur incapacité à capter un réel qui leur est devenu évanescent.

Lire aussi : « Fake news », pure player, leaks, complotisme, datas…quand les médias mutent

Conscients qu’un échantillon – aussi bien constitué soit-il – n’est qu’une figuration limitée, et donc forcément inadéquate du corps électoral, les sondeurs ont depuis longtemps recours à des méthodes correctives, dites de « redressement ». Sommairement, il s’agit de compenser un biais par ajustement des pondérations affectées à certains individus d’un échantillon donné appartenant à une catégorie mal représentée. En pratique, c’est par l’analyse rétrospective des sondages passés et de la réalisation effective du comportement des électeurs par rapport aux modélisations statistiques, que sont effectués les redressements. La compensation nécessaire du phénomène de sous-déclaration des votes d’extrême-droite est un cas paradigmatique en la matière : depuis l’autocensure dans l’expression du vote conservateur après plus d’une décennie de thatchérisme à l’occasion des législatives britanniques de 1992, jusqu’à la mauvaise appréhension répétée du suffrage frontiste en France au cours de ces vingt dernières années, les illustrations abondent.

Un redressement improductif

Tant que le présent reste suffisamment homogène au passé qui lui sert de référence de calibration, les techniques de redressement s’avèrent généralement pertinentes. C’est pour cela même que l’élection présidentielle qui vient de s’achever a été correctement anticipée par les sondeurs : Jean-Luc Mélenchon a naturellement capté l’électorat de Benoît Hamon par effet de déversement, le Front National est désormais relativement normalisé, les « affaires » Fillon ont eu le temps d’être digérées par les électeurs tant elles ont été graduellement distillées et Emmanuel Macron n’a fait autre que de reprendre la place laissée vacante par le Centre historique. Les équilibres traditionnels ont eu le temps de s’établir, sur la base d’un corps électoral en cohérence avec ce qu’il a pu être lors des scrutins présidentiels passés.

Lire aussi : L’inquiétante progression de la confusion intellectuelle

En revanche, dès lors que le présent se singularise vraiment, cette méthode ne suffit plus ; l’écart entre l’échantillon et le réel qu’il est censé représenter se creuse alors inexorablement. Or, la post-postmodernité de notre temps est faite de ces ruptures qui remettent en cause les références traditionnelles au passé : la désintermédiation économique, l’ubiquité de l’information, le primat de l’individu, le droit-de-l’hommisme érigé en valeur cardinale sont autant de sources de perturbation des schémas existants.

Par ailleurs, la récence du processus de primaires en France, comme la singularité de la candidature Trump aux États-Unis relèvent de configurations électorales elles-mêmes particulières. À l’indécision technique relative à la « représentativité » des échantillons, s’adjoint une incertitude de second ordre quant à la composition même et au comportement du corps électoral effectif. Cette dernière est en outre amplifiée par l’interconnexion toujours plus importante des personnes et des systèmes, créant, par le truchement naturel de la combinatoire, des configurations moins prédictibles (des événements rares), donc des cadres d’analyse moins accessibles aux modélisateurs.

De l’épiderme des peuples

Mais il serait vain de ne chercher d’explication à l’échec des sondeurs qu’au travers de la critique technique de leur méthode. Car ce qui est à l’œuvre, ce n’est pas seulement l’inadéquation d’un corpus analytique, mais le dysfonctionnement d’un système considéré dans son entièreté. Bien que les instituts de sondage se défendent d’établir des prédictions, se contentant de revendiquer la production de séries de « photographies de l’opinion », la surutilisation de ces dernières, galvaudées par un système médiatique que le jeu concurrentiel échauffe, laisse planer le doute quant à la vocation de ce qui est réellement établi. Lorsque leurs annonces s’avèrent conformes aux événements réalisés, les sondeurs ne manquent pas de vanter à l’envi leur précision prédictionnelle, se défendant en revanche de toute velléité de la sorte dès lors que le réel se rebiffe.

Pour les peuples, les sondeurs sont perçus comme les chevilles ouvrières d’un système politico-médiatique qui leur est de plus en plus étranger et duquel il est nécessaire de se défaire. En votant Donald Trump, en plébiscitant le Brexit, c’est aussi le malaise d’une civilisation face à ses « élites » que l’opinion cherche à exprimer. Par un retournement insigne, la statistique serait devenue l’une des composantes majeures de cette doxa que les peuples abhorrent.

À mesure qu’il prend conscience de lui-même, le Léviathan d’Alain se rend insaisissable. Si sa liberté est à ce prix, les sondeurs le paieront, bon gré mal gré.

[1] Conseil britannique des sondages.

[/vc_column_text][/vc_column][/vc_row]

EN KIOSQUE

Découvrez le numéro du mois - 6,90€

Soutenez l’incorrect

faites un don et défiscalisez !

En passant par notre partenaire

Credofunding, vous pouvez obtenir une

réduction d’impôts de 66% du montant de

votre don.

Retrouvez l’incorrect sur les réseaux sociaux

Les autres articles recommandés pour vous

Restez informé, inscrivez-vous à notre Newsletter